An den Einsatz von KI im industriellen Umfeld werden hohe Anforderungen an die zu integrierende Logik gestellt, denn bei schnellen Prozessen – wie bei Inspektionssystemen – gibt es oft keine weitere Kontrollinstanz. Deshalb muss bei industriellen KI-Systemen stets sichergestellt werden, dass die Entscheidungsfindungsprozesse der KI-Systeme nachvollziehbar und auch immer korrekt sind. Das Training der KIs ist im industriellen Umfeld deshalb komplex. Auch gibt es kaum Negativbeispiele. In der Industrie müssen Fehler von Anfang an vermieden werden. Daher werden hier häufig digitale Twins eingesetzt, um Negativbefunde zu simulieren und dadurch beispielsweise gewisse Bewegungsabläufe von Robotern von vorneherein auszuschließen. Wie entwickelt und betreibt man also fehlerfreie industrielle KI für Echtzeitanforderungen?

GPGPU: eine wichtige Technologie für KI

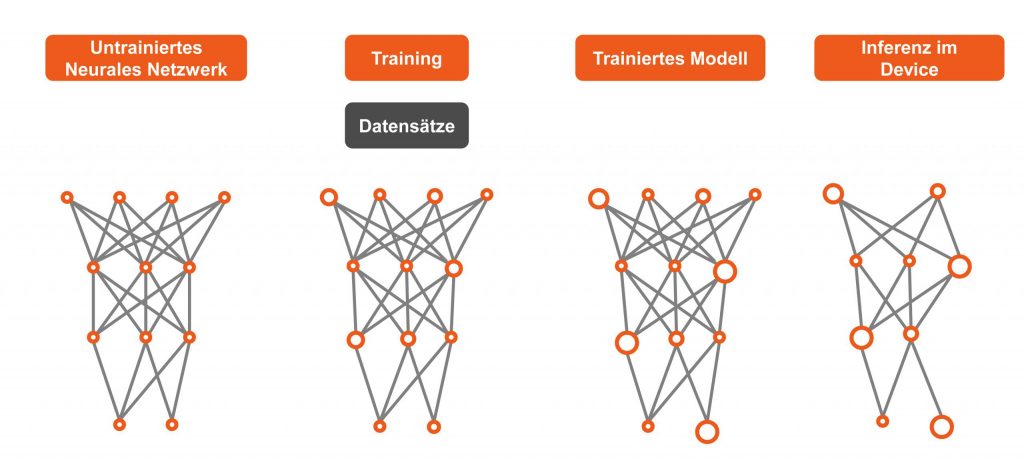

Bei den meisten Systemen erfolgt die Hauptarbeit der Mustererkennung in der GPGPU-gestützten Cloud mit ihrer immensen parallelen Rechenleistung. In der produzierenden Industrie ist das jedoch – zumindest derzeit noch – ein Ausschlusskriterium, da es oft um schnelle Prozesse geht. Hier muss man also dafür sorgen, dass sich die Intelligenz am Edge befindet, weshalb in den Geräten, Maschinen und Anlagen der Industrie auch zumeist KI Systeme im Einsatz sind, die für Echtzeit-Applikationen wissensbasierte Intelligenz anwenden und Daten für Deep Learning an zentrale Clouds weiterleiten, die aktuell noch nicht in Echtzeit angeschlossen werden können. Möglich ist es also schon heute, ein übergeordnetes System mit allen neuen Daten weiter zu trainieren und die lokalen Devices über regelmäßige Softwareupdates auf den aktuellen Stand des Wissens zu bringen, sodass man solche Systeme schon heute als selbstlernende Systeme einstufen kann. Das Lernen findet hier nur weniger als Lernkurve sondern in zyklischen Update-Stufen statt. Dies ist auch ein Grund, weshalb Themen wie die digitalen Zwillinge oder industrielle Edge-Server so wichtig sind: Kann man beides bereitstellen, kann selbst Deep Learning zunehmend echtzeitfähig werden.

Die passenden Embedded-Prozessoren

Ganz gleich, welches Setup OEM für ihre KI wählen: Bezogen auf die einzelne echtzeitfähige Maschine oder Anlage sind die Anforderungen an die benötigte Verarbeitungsleistung auch bei ’normaler‘, rein wissensbasierter KI immer noch sehr hoch. Neueste Embedded Accelerated Processing Units (APUs) von AMD unterstützen diesen Bedarf, da sie neben dem klassischem x86er Prozessor eine leistungsfähige GPU bieten, die über ihre General Purpose Funktionen auch parallele KI-Rechenprozesse unterstützt, wie sie in den Rechenzentren zur Anwendung kommen. Diese lässt sich zudem über diskrete Embedded GPUs des gleichen Herstellers weiter skalieren, sodass man die offene parallele Rechenperformance genau an den Bedarf der industriellen KI-Applikation anpassen kann.

AMD Ryzen Embedded V1000

Mit ihrer gestiegenen Rechen- und Grafikleistung empfiehlt sich dabei die energiesparende und industriell-robuste AMD Ryzen Embedded V1000-Series. Sie bietet mit einer Gesamtleistung von bis zu 3,6 TFLOPs aus der Multi-Purpose CPU und der leistungsstarken General Purpose Grafikeinheit eine flexible Rechenleistung, die vor wenigen Jahren nur mit Systemen erreichbar war, die mehrere hundert Watt verbrauchten. Heute ist diese Rechenleistung schon ab 15 Watt verfügbar. Damit kann sie selbst in lüfterlose und komplett geschlossene und damit höchst robuste Geräte für den Fabrikeinsatz integriert werden. Als echtzeitfähige Prozessoren unterstützen sie zudem auch Speicher mit Error Correction Code (ECC), was für die meisten industriellen Maschinen und Anlagen essenziell ist.

Umfassender Softwaresupport

Auch in Bezug auf das nötige Software-Environment für eine schnelle und flächendeckende Einführung von KI und Deep Learning bieten diese AMD Embedded Prozessoren umfassenden Support an Tools und Frameworks wie TensorFlow, Caffe und Keras. Besonders wichtig ist dabei der Open Source Gedanke, damit OEMs nicht von einer proprietären Lösung abhängig sind. So steht hier auch das Tool HIPfy zur Verfügung, mit dem sich proprietäre Applikationen in portable HIP C++ Applikationen portieren lassen, so dass die gefährliche Abhängigkeit von einzelnen GPU-Herstellern wirkungsvoll vermieden werden kann. KI zu entwickeln ist zudem auch mit der Verfüfgbarkeit von OpenCL 2.2 deutlich einfacher geworden, denn seitdem ist die OpenCL C++ Kernel Sprache in OpenCL integriert, was das Schreiben parallel arbeitender Programme deutlich erleichtert. Mit einem solchen Ökosystem sind sowohl wissensbasierte KIs als auch Deep Learning vergleichsweise einfach umzusetzen und nicht nur den milliardenschweren IT-Giganten wie Google, Apple, Microsoft und Facebook vorbehalten.

Schnelles Design-in mit Computer-on-Modules

Jetzt bleibt nur noch die Frage, wie OEMs diese hardwareseitigen KI-Enabler möglichst schnell und effizient in ihre Applikationen eindesignen können. Einer der effizientesten Wege führt über standardisierte Computer-on-Modules, die mit umfassendem Support für das GPGPU-Processing ausgestattet wurden. Man davon ausgehen, dass OEM beim Einsatz von Computer-on-Modules rund 50 bis 90 Prozent Ihrer NRE-Kosten sparen. Durch den modularen Ansatz der Module wird die Applikation zudem auch bedarfsgerecht skalierbar: Durch einen einfachen Tausch lassen sich ohne weiteren Designaufwand auch neue Leistungsklassen auf vorhandene Carrierboard-Designs integrieren, sodass OEMs die Funktionalität ihrer Designs leicht um diese innovativen Features erweitern können.

COM Express – der Standard für High-End Module

Der Formfaktor unter den Modulen für diese Leistungsklasse ist der Standard COM Express, der von der PICMG herstellerunabhängig seit vielen Jahren weiterentwickelt wurde und der von allen führenden Embedded Computing Lieferanten unterstützt wird. Unternehmen wie congatec bieten AMD Ryzen Embedded V1000 Prozessor basierte Module beispielsweise im COM Express Basic Type 6 Formfaktor an, der hinreichend Kapazität bietet, die gesamte Performancerange von 15 bis 54 Watt TDP abzudecken. Dank RTS-Hypervisor Support kann das echtzeitfähige conga-TR4 Modul zudem KI Plattformen unterstützen, bei denen die Anbindung von Deep Learning Systemen und Digitalen Twins über Virtuelle Maschinen umgesetzt werden soll, sodass die harte Real-Time Processing stets sichergestellt werden kann. Und auch für den UIC-Standard der SGET für den Datenaustausch über IoT-Gateways ist das Modul dank seiner standardisierten APIs vorbereitet, sodass sich OEM Kunden voll und ganz auf die Entwicklung der Applikation konzentrieren können. Fehlende ‚Glue Logic‘ kann auf Kundenanforderung jederzeit auch bedarfsgerecht entwickelt und bereitgestellt werden.

Embedded High-End Edge-Server Design Optionen

Wollen OEM ihre Digitalen Zwillinge und Deep Learning Intelligenz zudem in das industrielle Edge bringen, stellt congatec hierfür ebenfalls Optionen bereit: Embedded Designs auf Basis der neuen, bis zu zehn Jahren langzeitverfügbaren AMD EPYC Embedded 3000 Prozessoren. Die Prozessoren der Embedded Server Klasse ermöglichen mit ihren bis zu 16 Cores, 10 Gigabit Ethernet Performance und bis zu 64 PCIe Lanes selbst Deep Learning Applikationen am Edge des IIoTs, sodass Entwicklern damit alles zur Verfügung gestellt wird, was sie von Seiten der Hardwareplattformen für Deep Learning basierte KI Plattformen im industriellen Echtzeit-Einsatz benötigen.