Ob bei Automotive-Zulieferern, Elektronik-Herstellern oder Anbietern von Haushaltsgeräten; wo immer einzelne Komponenten manuell montiert werden, geschehen Fehler. Um diese sicher zu erkennen, analysiert das intelligente Kamerasystem Schlauer Klaus von Optimum ein hochauflösendes Bild jedes fertig montierten Stücks und gleicht dieses mit Bildern von Gut- und Schlecht-Zuständen ab. „In den letzten Jahren haben wir aber immer wieder erkannt, dass die Notwendigkeit zum Einlernen von Schlecht-Bildern den Einsatz von kognitiven Assistenten wie unserem Schlauen Klaus massiv behindert. Wir wollen eine Lösung schaffen, die es unseren Kunden ermöglicht, ausschließlich mit Bildern des regulär laufenden Prozesses zu starten und trotzdem Abweichungen von der Norm erkennen zu können“, beschreibt Optimum-Geschäftsführer Wolfgang Mahanty die Motivation, sein System noch schlauer zu machen. Unterstützung bei der Entwicklung fand Optimum bei Industrial Analytics Lab, die auf die Implementierung von KI-gestützten Automationslösungen im Mittelstand spezialisiert sind. Gemeinsam wurden eine Algorithmik entwickelt, um Fehlerzustände zu erkennen, ohne diese vorher gesehen zu haben.

Self-Organizing Maps (SOMs)

Möglich wird dies durch den Einsatz von Self-Organizing Maps (SOMs). Diese Neuronalen Netze gehören zu den unsupervised-learning Methoden, d.h. eine Klassifikation von Bilddaten wird ohne a priori Wissen ausschließlich basierend auf algorithmisch identifizierter Ähnlichkeit der Bilder durchgeführt. Dies ermöglicht Klassifikationsaufgaben ohne vorherige Kenntnis der Anzahl und Art der zu bildenden Klassen. Befinden sich in einem Satz Bilddaten etwa Bilder von Hunden, Katzen und Mäusen, so wird die SOM eine Gliederung ganz von selbst herausbilden. Kommt z.B. die Fotografie eines Vogels hinzu, wird diese in keine der drei Teile der Karte einsortiert werden können und entsprechend als Ausreißer hervortreten. Mittels SOMs kann sogar ein Bestimmtheitsmaß für die erfolgte Klassifikation ermittelt werden, da der Abstand in der Karte ein direktes Maß für die Ähnlichkeit darstellt. Mit der Implementierung des SOM-Ansatzes, der bereits viele Anwendungsfälle von Optimum beinhaltet, gelingt diese Outlier-Detektion für nahezu alle getesteten Fälle.

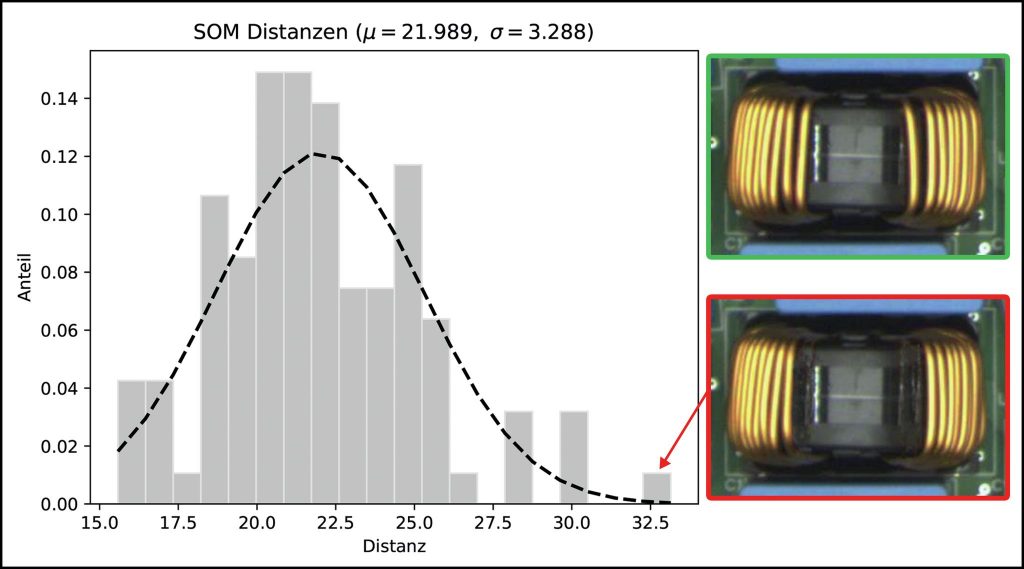

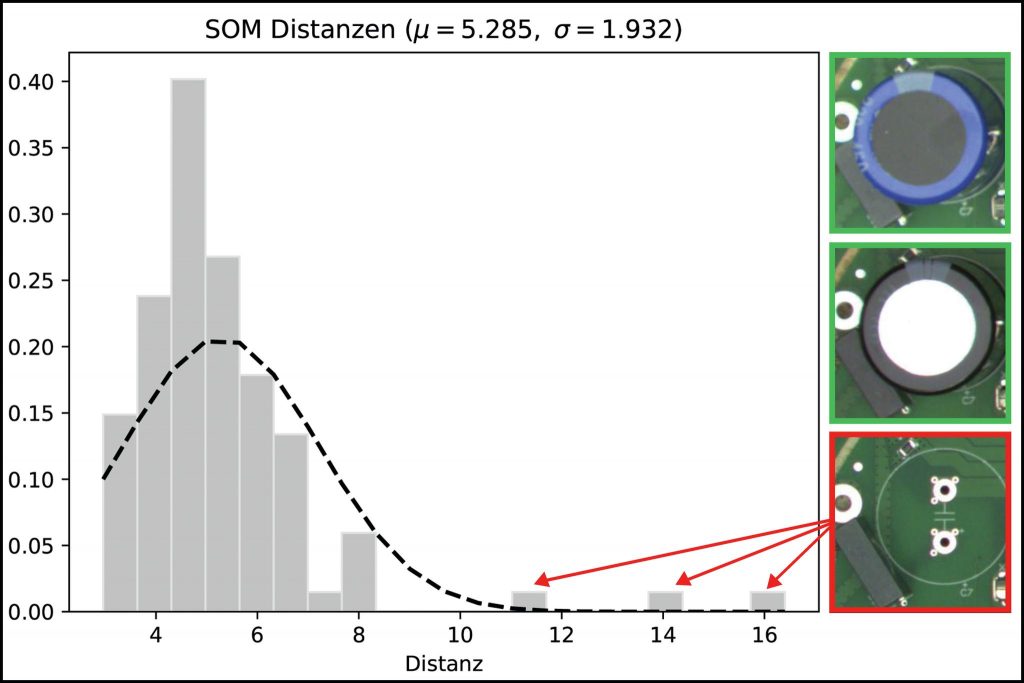

Beim IAL wurde der SOM-Ansatz mittlerweile an echten Trainingsfällen von Optimum erprobt, so etwa bei der manuellen Endbestückung von Elektronik-Platinen. Hier werden einige Teile händisch aufgebracht, die zu massiv für den Bestückungsautomaten sind. Sehr selten kommt es dabei vor, dass ein solches Bauteil wie eine Spule oder ein Kondensator vergessen wird. Um diesen Fall ausschließlich mit Bildern von korrekt bestückten Platinen abzudecken, genügen in Zukunft die ersten 100 Gut-Bilder zum Anlernen der SOM. Sie erhält damit Kenntnis über die prozess-intrinsische Varianz, die als normal zu erachten ist, und quantifiziert diese in einem mittleren Abstand der einzelnen Bauteile zueinander. Tritt nun der Fall ein, dass etwa ein Kondensator vergessen wurde, so erkennt die SOM den Unterschied des einen Bildes zu allen bisherigen und platziert es daher in großem Abstand zu den anderen. Anhand des Abstandes kann so quantifiziert werden, wie ähnlich ein einzelnes Bild zu den bisherigen ist.

Parallelen zum menschlichen Sehen

Bilder, die für das menschliche Auge einfach unterscheidbar sind, werden auch durch die SOM gut getrennt und umgekehrt. Durch dieses natürliche Lernen wird die Handhabung des Verfahrens erleichtert, da die Klassifikationsgüte mit dem menschlichen Empfinden der Schwierigkeit des Problems korreliert. Bild 1 zeigt eine SOM, die für die Bewertung einer Ringspule auf einer Platine antrainiert wurde. Das injizierte Fehler-Bild, bei dem die Ringspule eine Wicklung zu wenig aufweist, ist für den Menschen nur schwer von einem Gut-Bild zu unterscheiden. Entsprechend schlechtere Resultate liefert hier auch die SOM, die das injizierte Fehler-Bild lediglich ganz knapp außerhalb des angestrebten 3 Konfidenzintervalls zeigt. Mit diesen Labor-Resultaten können Optimum und IAL zeigen, dass SOMs in der Lage sind, auch kleine Abweichungen in einer Reihe von Bilddaten sicher zu klassifizieren. Die Tatsache, dass SOMs dabei (a) keine Vorgaben hinsichtlich der Art oder Anzahl von Klassen benötigen und (b) die intrinsische Möglichkeit der Angabe eines Bestimmtheitsmaßes für die erfolgte Klassifikation liefern, macht sie überlegen gegenüber supervised-learning KI-Methoden. Der SOM-Einsatz wird nun bei ausgewählten Pilot-Kunden von Optimum im regulären MontageAblauf erprobt werden.